Inteligência Artificial (IA) enfrenta dois grandes obstáculos atualmente: a crescente demanda por poder computacional e o alto custo de treinamento de modelos de em grande escala. E isto está resultando na centralização da indústria, onde somente empresas, com grande capacidade de orçamento, são capazes de conduzir pesquisas e produzir modelos IA de ponta.

Tendo isto em conta, vários projetos cripto estão construindo soluções descentralizadas para superar estes desafios, através de redes abertas de computação e inteligência de máquina. Eis o tema de nosso artigo de hoje.

Leia mais: Sofri um golpe, e agora? Como agir em casos de fraude

Leia mais: Sofri um golpe, e agora? Como agir em casos de fraude

Mas como jargões técnicos são um dos maiores entraves à compreensão de qualquer assunto, vamos começar com alguns “conceitos” essenciais.

Conceitos essenciais ao artigo

IA e Machine Learning (ML) são frequentemente usadas como sinônimos, mas a aprendizagem de máquinas é uma subespécie do gênero IA.

Inteligência artificial é o campo da ciência da computação responsável por desenvolver algorítmos e modelos para imitar o pensamento humano e executar tarefas que requerem inteligência humana – tomada de decisões, percepção, raciocínio.

Machine Learning (ML), “aprendizagem de máquinas” em português, é um campo dedicado à compreensão e construção de sistemas que “aprendem” – ou seja, modelos que aproveitam os dados para melhorar o desempenho em algumas tarefas. ML é uma parte da inteligência artificial.

SponsoredComo nada melhor que um exemplo para compreender algo, ML está por trás de chatbots e textos preditivos, aplicativos de tradução de idiomas, filmes e séries que a Netflix sugere a você, bem como na forma como seus feeds de mídia social são apresentados a você. É o ML que alimenta veículos e máquinas autônomas capazes de diagnosticar condições médicas com base em imagens.

O Machine learning também está associado a vários outros subcampos de inteligência artificial como Redes Neurais e Deep Learning.

Neural Networks (NN) – Redes Neurais – são uma classe específica e comumente usada em ML. Tais redes são modeladas no cérebro humano, onde milhares ou milhões de nodes de processamento estão interconectados e organizados em camadas.

Deep Learning Networks (DP) – Redes de aprendizagem profunda – são redes neurais com múltiplas camadas de nós interligados trabalhando em tandem para analisar dados de entrada e gerar uma saída. Essa rede em camadas pode processar grandes quantidades de dados e determinar o “peso” de cada ligação na rede.

Em um sistema de reconhecimento de imagem, algumas camadas da NN podem detectar características individuais de um rosto, como olhos, nariz ou boca, enquanto outra camada seria capaz de dizer se essas características aparecem de uma forma que indique um rosto.

Aqui, importante destacar que todos esses subcampos de inteligência artificial “utilizam e processam” grandes quantidades de dados.

Quais pilares sustentam a evolução da IA ?

As tecnologias estão em constante progresso. Elas continuam se aperfeiçoando ao longo do tempo, e com IA não poderia ser diferente.

Nesse passo, a ascensão da IA se baseia em três pilares: novos algoritmos, dados e cálculos.

Para que modelos de IA processem e analisem dados de forma cada vez mais eficiente e precisa, é necessário o constante desenvolvimento de novos algorítmos e técnicas.

Também, todos os subcampos de IA utilizam e processam grandes conjuntos de dados no treinamento de seus modelos.

De outro lado, o treinamento de modelos de IA exige cálculos complexos em grandes quantidades de poder de processamento computacional.

Contudo, é nos pilares impulsionadores do desenvolvimento da IA onde se encontram os seus dois principais desafios.

Os dois grandes desafios da indústria

Para evitar uma desaceleração, a indústria de Inteligência Artificial precisa resolver dois grandes desafios que estão diretamente relacionados aos seus pilares de desenvolvimento.

1º) A crescente demanda por poder computacional

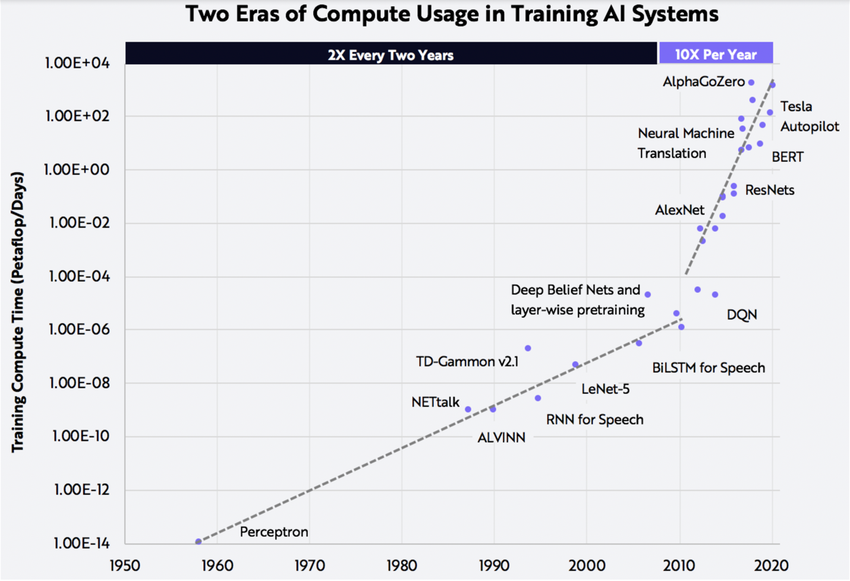

Os cálculos exigidos pelos modelos de IA estão aumentando em uma progressão geométrica, e fornecimento de recursos computacionais não estão acompanhando as exigências da indústria.

2º) Os altos custos para treinamento de modelos de IA em larga escala

Relatório publicado em 2021, apontou a obtenção de dados como o principal obstáculo enfrentado pelas empresas de IA em sua busca pelo desenvolvimento da tecnologia.

Os custos para o treinamento de modelos de IA em larga escala aumentaram durante a última década em torno de 3100% ao ano. Para se ter uma ideia do aumento deste custo, veja figura 1.

Lembre-se que o treinamento de modelos de ML requer o uso de um grande número de GPUs por longos períodos de tempo.

Em razão disso, as empresas de AI geralmente precisam enfrentar uma dura escolha: ou investem no desenvolvimento de seu próprio hardware, ou devido à alta demanda, pagam preços inflacionados para provedores de clouds.

Sponsored SponsoredEnquanto as empresas maiores como OpenAI podem se dar ao luxo de escolher fornecedores de cloud, empresas menores como Stability.AI podem não esta opção de escolha devido ao alto custo do capital. Startups e pequenas empresas são forçadas a reduzir os gastos com cloud, comprometendo seu avanço na indústria.

Para se ter uma idéia do que estamos falando aqui, o GPT-3 da OpenAI foi treinado usando 1.000 GPUs Nvidia V100, que lhe custaram US$ 12 milhões. Já o modelo desenvolvido pela Stability.AI precisou de 4.000 GPUs Nvidia A100 rodando na nuvem da AWS, ao custo de mais de US$ 50 milhões ao mês.

Ora, este alto custo não só coloca os pequenos laboratórios de pesquisa ML em desvantagem, como também concentra o desenvolvimento de IA empoucas empresas de tecnologia, o que levou líderes mundiais a assinarem uma carta aberta

Por que líderes mundiais querem uma pausa nos experimentos com IA?

Parte significativa do desenvolvimento da IA está sendo realizada à porta fechada em grandes empresas de Tecnologia, que competem entre si e, por isso, mantêm seus modelos privados.

No entanto, essa “centralização” no desenvolvimento de IA, segmentada por poucos conglomerados de tecnologia é considerada anti-ética e um enorme risco à sociedade.

Vamos supor que uma equipe de pesquisa independente de uma Universidade deseje desenvolver uma versão mais poderosa de um modelo de IA. Para isto, ela precisaria reeducar o modelo a partir do zero, reaprendendo tudo no qual o modelo já existente foi treinado.

Pois bem, considerando os altos custos de treinamento de IA que vimos nos parágrafos anteriores, isto gera uma barreira de entrada aos pequenos laboratórios de pesquisa ML e colocando o controle do futuro do desenvolvimento da IA na mão de poucos.

Bem por isso, líderes mundiais como Elon Musk, Yuval Harari e Steve Wozniak assinaram uma carta aberta para uma pausa nos experimentos com Inteligência Artificial.

A principal motivação dessa carta é que IA tem uma escala e impacto global gigantescos, e os caminhos da humanidade não podem ficar nas mãos de meia dúzia de empresas – o futuro da humanidade deve ser cocriado.

Pois bem, agora que você já sabe os desafios que IA precisa superar para continuar se expandindo, e compreendeu por que a centralização do desenvolvimento de IA é um risco à sociedade, vamos entender como projetos cripto podem ajudar.

Redes Computacionais Descentralizadas

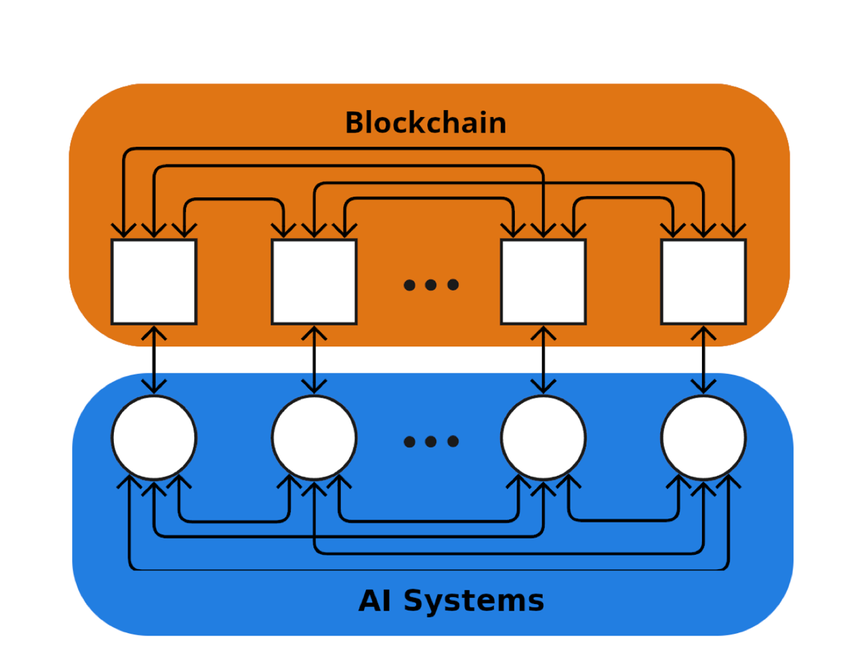

As redes de computação descentralizadas para Machine Learning conectam entidades que buscam recursos computacionais a sistemas com capacidade ociosa de computação, incentivando a contribuição de recursos de processamento para a rede.

Como o fornecimento dessa capacidade ociosa não requer custos adicionais, as redes descentralizadas podem oferecer preços mais baixos em comparação com os provedores tradicionais centralizados.

Tipos de redes de computação descentralizadas

Redes de computação de propósito geral operam como uma nuvem descentralizada, provendo recursos de computação para uma variedade de aplicações.

Já redes de computação para fins específicos são destinadas a casos de uso específicos.

Render Network: rede de computação descentralizada de propósito geral para ML

A Render Network (RNDR) é um belo exemplo de rede de computação descentralizada de propósito geral.

SponsoredEla é uma plataforma de computação GPU distribuída peer-to-peer em blockchain que democratiza a computação e o poder de renderização, disponibilizando fácil acesso a ferramentas de realidade aumentada para que criadores de conteúdo possam criar arte digital em ambientes 3D.

O funcionamento da Render Network

A Render é projetada para conectar os usuários que procuram realizar trabalhos de renderização com pessoas ou empresas que possuem GPUs ociosas para processar os renderizadores.

Os proprietários conectam suas GPUs à Render Network a fim de receber e completar os trabalhos de renderização usando OctaneRender. Em troca, os usuários enviam o token RNDR para o indivíduo que executasse o trabalho de renderização.

Quando os fornecedores da capacidade computacional registram suas GPUs ociosas na Rede de Renderização, estes proprietários de GPUs se tornam “Operadores de Nó” e podem ganhar Tokens RNDR. Eles fazem isto ao aceitar trabalhos de usuários que necessitam de renderização. Conhecidos como “Criadores”, estes usuários enviam seus arquivos para a Render Network, que os designa para Operadores.

A Render Network recebe uma pequena porcentagem dos tokens RNDR pagos, a fim de manter a rede e facilitar a transação.

Pois bem, conquanto a maioria das cargas de trabalho de computação ML possa funcionar em uma cloud descentralizada, há casos em que é conveniente utilizar para uma rede de computação de propósito específico.

Hipóteses em que o uso de Redes de Computação descentralizadas específicas é recomendável

Rede de computação descentralizada de propósito específico são recomendáveis para “paralelização” e para verificação de uma parte do treinamento de ML.

Seu uso para “paralelização”

Como o treinamento desses modelos depende do estado atual do cálculo, é muito complexo alavancar uma rede distribuída geral de GPUs.

Nesse caso, uma boa solução para treinar modelos de Deep Learning e ML é usar uma rede descentralizada projetada para realizar parte do treinamento em paralelo.

Seu uso para “verificação”

Muitas vezes, para treinar um modelo ML é preciso encontrar uma maneira de verificar o trabalho computacional sem repetir todo o cálculo, o que seria um desperdício de tempo e recursos. Neste caso, uma boa solução é utilizar uma rede de computação descentralizadas específicas projetada apenas para verificação do trabalho computacional.

Exemplos de redes de computação descentralizada específicas para ML

Gensyn

O Protocolo Gensyn é um blockchain de camada 1 não permissionado, ou seja, uma rede de computação descentralizada específica de ML. Ela encontrou uma solução para os problemas de paralelização e verificação no treinamento de modelos de IA de forma descentralizada e distribuída.

O protocolo utiliza a paralelização para dividir cargas de trabalho computacional maiores em tarefas, e as empurra de forma assíncrona para a rede. Para resolver o problema de verificação, o Gensyn usa prova de aprendizagem probabilística, um protocolo de pontos de referência baseado em gráficos, e um sistema de design de incentivos ao estilo Truebit.

Embora ainda não esteja ativa, a equipe prevê que o custo em horas para uma GPU equivalente ao V100 será de aproximadamente US$ 0,40. a base desta estimativa são os mineradores Ethereum que ganhavam de US $0,20 a US $0,35 por hora com uma GPU semelhante antes do the Merge.

Sponsored SponsoredNeste contexto, os custos de computação na Gensyn serão severamente “menores” que os serviços sob demanda ofertados pela AWS e GCP.

Together

O Together é basicamente uma cloud descentralizada para inteligência Artificial.

Projeto ainda em fase inicial, possui como foco inicial a construção de uma rede de computação descentralizada de propósito específico para a aprendizagem de máquinas.

O objetivo da Together é “criar um mundo onde qualquer pessoa possa contribuir e se beneficiar da IA avançada, reunindo recursos computacionais globais”.

Aqui, uma curiosidade. A Together iniciou seu projeto consolidando recursos de computação não utilizados (ociosos) de várias instituições. Eles incluem Stanford, ETH Zurich, Open Science Grid, Universidade de Wisconsin-Madison e CrusoeCloud, resultando em um total de mais de 200 PetaFLOPs de potência computacional.

Bittensor: Inteligência de Máquina Descentralizada

O Bittensor é um protocolo de código aberto que alimenta uma rede descentralizada de ML baseada em blockchain. Ele transforma a forma como os pesquisadores colaboram. Além disso, incentiva a produção de conhecimento em uma rede de código aberto com uma codificação padronizada de entradas e saídas para a interoperabilidade de modelos ML.

No Bittensor, os modelos ML treinam colaborativamente. Em seguida, os mineradores são recompensados com o patrimônio nativo da rede, TAO, de acordo com o valor informativo que eles oferecem ao coletivo. Isto é, eles são pagos pelas informações que trocam com outros usuários, além de acelerar seu aprendizado.

A rede TAO também concede acesso externo, permitindo que os usuários extraiam informações da rede enquanto ajustam suas atividades às suas necessidades.

Ou seja, o objetivo é criar um marketplace de IA, uma arena incentivada na qual consumidores e produtores podem interagir em contexto aberto e transparente.

Assim, a rede da Bittensor permite:

- Uma estratégia nova e otimizada para o desenvolvimento e distribuição de tecnologia de inteligência artificial. Isto facilita o acesso aberto/propriedade, governança descentralizada, e a capacidade de aproveitar recursos distribuídos de poder computacional global, além de possibilitar a inovação dentro de uma estrutura incentivada.

- Um repositório de código aberto de inteligência de máquina, acessível a qualquer pessoa, em qualquer lugar. Isto cria as condições para inovação aberta e sem permissão em escala global.

- Distribuição de recompensas e propriedade da rede aos usuários em proporção direta ao valor que eles agregaram à rede.

Em essência, Bittensor pretende se tornar a Internet da IA, funcionando como uma camada de coordenação de inteligência.

Pensamentos finais

A solução para a melhoria da eficiência do treinamento de IA pode estar nas redes descentralizadas ML. Isto permitiria o agrupamento de recursos e a abertura de oportunidades para que mais pessoas contribuam para modelos de IA em larga escala

Claro que ainda estamos nos estágios iniciais desses protocolos descentralizados, e ainda há alguns quilômetros a serem percorridos.

Mas e você? Compreendeu porque a centralização do desenvolvimento da IA é um Risco para a humanidade? Concorda com a iniciativa de carta aberta para paralisar procedimentos de Inteligência Artificial em larga escala?

Entendeu como redes de computação descentralizadas podem ajudar a contornar os dois principais desafios da indústria – obtenção de dados e acesso a recursos de poder computacional?

Tinha ideia do iminente risco de desaceleração do desenvolvimento da IA?

Conhecimento é poder!! Nos vemos em breve!

- Não entendeu algum termo do universo Web3? Confira no nosso Glossário!

- Quer se manter atualizado em tudo o que é relevante no mundo cripto? O BeInCrypto tem uma comunidade no Telegram em que você pode ler em primeira mão as notícias relevantes e conversar com outros entusiastas em criptomoedas. Confira!

- Você também pode se juntar a nossas comunidades no Twitter (X), Instagram e Facebook.