Com o Auto-GPT, estamos indo direto para o reino dos Agentes Autônomos de IA. Simplificando, o Auto-GPT é uma ferramenta potencialmente revolucionária que permite que modelos de linguagem grandes (LLMs) pensem, planejem e executem tarefas sem intervenção humana. Nesse sentido, é como o irmão mais independente do ChatGPT.

Há até rumores de que o Auto-GPT é um prelúdio para o AGI (Artificial General Intelligence). No entanto, não vamos colocar o carro à frente dos bois, vamos nos concentrar no que sabemos. Este artigo explora tudo o que você precisa saber sobre o Auto-GPT, seus recursos e como ele está transformando a maneira como interagimos com a inteligência artificial.

O que é o Auto-GPT?

O Auto-GPT é um assistente de IA com foco na autonomia. Esta interface experimental para o GPT-4 e o GPT-3.5 é capaz de realizar tarefas de forma independente sem a necessidade de qualquer intervenção humana. Ao contrário do ChatGPT, que requer prompts específicos para executar, o Auto-GPT assume as rédeas, gerando seus próprios prompts para realizar as tarefas definidas por você.

Pense assim: para realmente aproveitar o poder de um chatbot de IA como o ChatGPT, você precisa jogar um pouco como um quebra-cabeça de palavras com as consultas que você lança nele. Afinal, como se costuma dizer, a qualidade da saída de qualquer chatbot de IA dependerá em grande parte da qualidade dos prompts que você o alimenta. Mas e se pudéssemos contornar esse obstáculo e deixar o aplicativo descobrir os melhores prompts por conta própria? E dê um passo adiante – deixe-o descobrir as etapas subsequentes e como executá-las, iterando até que o trabalho esteja concluído. É isso que o Auto-GPT visa realizar.

Desenvoltura da IA

E não se trata apenas de inteligência, mas também de desenvoltura. O Auto-GPT pode acessar sites e mecanismos de pesquisa, coletar dados e — aqui está o ponto principal — autoavaliar a qualidade desses dados. Qualquer coisa abaixo da média é inicializada e o Auto-GPT volta para a prancheta de desenho digital, criando uma nova subtarefa para encontrar dados melhores. Consequentemente, ele ganha reconhecimento como um agente autônomo de IA.

Parece intrigante? Se você planeja experimentá-lo em primeira mão, precisará de uma conta OpenAI paga. Em seguida, obtenha uma API OpenAI, que atuará como uma ponte que permite que o Auto-GPT interaja com o GPT-4 e o ChatGPT do OpenAI.

Quanto ao custo, trata-se de tokens – a moeda da OpenAI para palavras. Um token equivale a aproximadamente quatro caracteres ou 0,75 palavras. O número de tokens que você envia como um prompt e recebe de volta determina o custo total.

Um tutorial rápido sobre como começar a usar o Auto-GPT

Ao contrário do ChatGPT, que você pode acessar sem esforço fazendo login na sua conta OpenAI e seguindo algumas etapas básicas, configurar o Auto-GPT no seu computador envolve um processo um pouco mais complexo. Aqui está o que você precisa fazer:

- Etapa 1: primeiro, certifique-se de ter o básico. Isso inclui Python 3.8 (ou mais recente) e chaves de API OpenAI. Você pode encontrar links de download para eles na página do GitHub do Auto-GPT.

- Etapa 2: Instalou as ferramentas? Ótimo! Agora vá para o GitHub, clique em ‘Código’ e baixe o arquivo Zip. Escolha a opção de branch ‘Stable’ à esquerda — ‘Master’ pode ser um pouco temperamental.

- Etapa 3: Abra o Power Shell e execute este código: git clone https://github.com/Torantulino/Auto-GPT.git’.

- Etapa 4: Agora, navegue até o diretório do projeto com: ‘cd Auto-GPT’

- Etapa 5: quando estiver no lugar certo, instale as bibliotecas com este comando: ‘pip install -r requirements.txt’

- Etapa 6: Finalmente, renomeie ‘env. template’ para ‘.env’ e insira sua OPENAI_API_KEY.

Pronto! O Auto-GPT agora está pronto para rolar. Nomeie seu bot e comece a brincar.

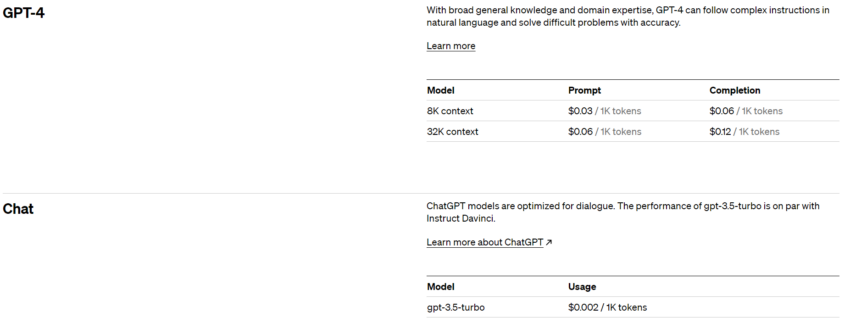

Quanto às APIs OpenAI, há duas opções para escolher no momento em que este artigo foi escrito – uma com 8.000 contextos e outra com 32.000 contextos. Como você pode ver na imagem abaixo, os preços dependem do modelo que você escolher e podem ser bastante caros se você não for cuidadoso com isso. Discutiremos essas desvantagens em detalhes mais adiante neste artigo.

Opções de APIs

No entanto, você não precisa se preocupar muito em ficar quebrado. Você pode definir limites de gastos flexíveis e rígidos sobre quanto deseja gastar em APIs. Se você definir um limite flexível, o OpenAI enviará um e-mail de notificação para alertá-lo de que você atingiu o limite definido. O limite rígido é mais eficaz porque o OpenAI encerra automaticamente todos os serviços relacionados à API quando você atinge o limite.

O que é “contexto” em grandes modelos de linguagem?

Para quem está boiando e não entende nada, “contexto” aqui se refere ao texto anterior ou às informações que o modelo usa para gerar suas respostas. Você sabe como em uma conversa, você se lembra do que foi dito para poder responder de acordo? Bem, é assim que o GPT-4 e outros modelos de linguagem também funcionam. Eles usam o que chamamos de “contexto” — todo o texto anterior — para descobrir o que dizer a seguir.

Imagine que você só consegue se lembrar das duas últimas frases de uma conversa. Isso seria bastante limitante. Portanto, esses modelos de IA têm uma “janela de contexto” — é como a memória de curto prazo do modelo.

A partir de maio de 2023, o GPT-4 é capaz de lidar com mais de 25.000 palavras de texto, o que representa um “contexto” muito mais longo oferecido pelos modelos GPT anteriores.

Auto-GPT: uma visão geral

Pense no Auto-GPT como um assistente de IA engenhoso. Você atribui uma missão a ele e faz um brainstorming de um roteiro para realizá-la. Se a tarefa envolver navegação na Internet ou recuperação de dados, o Auto-GPT recalibra sua estratégia até que a missão seja cumprida.

É como ter um assistente pessoal capaz de lidar com uma variedade de tarefas, desde análise de mercado e atendimento ao cliente até finanças e muito mais.

Aqui estão as quatro engrenagens principais que impulsionam o Auto-GPT::

- Arquitetura: Auto-GPT aproveita a força dos modelos GPT-4 e GPT-3.5 como seu mecanismo cognitivo, ajudando-o a pensar e resolver problemas.

- Recursos autônomos: esse é o mecanismo de autoaperfeiçoamento do Auto-GPT. Ele pode refletir sobre seu desempenho, alavancar esforços anteriores e utilizar seu histórico para fornecer resultados mais precisos.

- Gerenciamento de memória: Integrado com bancos de dados vetoriais, uma forma de armazenamento de memória, o Auto-GPT mantém o contexto e toma decisões mais informadas. É como o arquivo de memória de longo prazo do bot.

- Multifuncionalidade: com recursos como manipulação de arquivos, navegação na web e coleta de dados, o Auto-GPT é uma ferramenta multidimensional, um avanço em relação aos avanços anteriores da IA.

Portanto, o Auto-GPT é basicamente um robô sem forma física que utiliza IA e grandes modelos de linguagem para lidar com uma vasta gama de tarefas, aprender com seu passado e aprimorar continuamente seu desempenho.

No entanto, é importante lembrar que essas possibilidades empolgantes podem não refletir totalmente os verdadeiros recursos que o Auto-GPT pode oferecer atualmente. Então, vamos dar uma olhada rápida em algumas das limitações e desafios que o Auto-GPT, em sua fase atual, enfrenta.

Limitações do Auto-GPT

O fator de custo

A implantação do GPT-4, que forma a estrutura do Auto-GPT, tem um custo considerável. Cada etapa “cognitiva” dentro de uma sequência de tarefas aciona uma taxa simbólica para o processamento dedutivo do GPT-4 e solicitação de acompanhamento.

Com uma janela de contexto de 8K, o custo é de US$ 0,03 por 1.000 tokens para prompts e US$ 0,06 por 1.000 tokens para saídas. Assumindo a utilização máxima da janela de contexto, dividindo 80% de prompts e 20% de saídas, cada etapa incorre em uma cobrança de US$ 0,288.

Agora, a tarefa simples média pode exigir até 50 passos (ou até mais). Isso significa que mesmo uma única tarefa relativamente simples pode acabar custando até (US$ 0,288 x 50 =) US$ 14,40. Essa grande despesa operacional torna o Auto-GPT, em sua forma atual, financeiramente inviável para muitos usuários e entidades em potencial.

A questão “perpetuamente preso em um loop”

Você pode argumentar que, se o Auto-GPT puder simplificar seu fluxo de trabalho e realizar tarefas com sucesso, as taxas substanciais da API OpenAI podem ser vistas como uma despesa justificável. Mas isso pode não ser sempre o caso.

Verifique subreddits como r/autogpt ou qualquer fórum on-line semelhante e você encontrará muitos usuários reclamando que o Auto-GPT costuma tropeçar nos próprios pés. Mesmo com base em nossa própria experiência, o Auto-GPT geralmente cai em loops de processamento em vez de produzir as soluções prometidas.

Apesar de seus recursos avançados, o escopo de solução de problemas do Auto-GPT é limitado pela estreita gama de funções que ele oferece e pelas habilidades de raciocínio ainda imperfeitas do GPT-4.

O código-fonte do Auto-GPT indica um conjunto limitado de funções — incluindo pesquisa na web, manipulação de memória, interação de arquivo, execução de código e geração de imagem — que reduz o espectro de tarefas que ele pode manipular com competência. Além disso, embora o GPT-4 tenha mostrado melhorias em relação ao seu antecessor, sua capacidade de raciocínio ainda está longe do ideal. Isso frequentemente resulta em loops em vez de soluções.

Aplicações do Auto-GPT

O Auto-GPT vai além dos limites dos chatbots de IA “comuns”, como o ChatGPT. Por exemplo, tem potencial para supervisionar e implementar o desenvolvimento completo de aplicativos de software. Da mesma forma, em negócios e gerenciamento, o Auto-GPT pode aumentar de forma autônoma o patrimônio líquido de uma empresa examinando suas operações e fornecendo recomendações perspicazes para melhorias.

A capacidade do Auto-GPT de acessar a Internet permite que ele realize tarefas como pesquisa de mercado ou comparações de produtos com base em critérios especificados. Além disso, o Auto-GPT pode ser autoaperfeiçoado, capaz de criar, avaliar, revisar e testar atualizações em seu próprio código, aumentando potencialmente sua eficiência e recursos. A IA também pode potencialmente acelerar o processo de criação de LLMs superiores, estabelecendo as bases para a próxima geração de agentes de IA.

Aplicações do Auto-GPT em poucas palavras

Desde a criação de podcasts e análise de ações até a criação de software e desenvolvimento de mais bots de IA – usuários de todo o mundo estão colocando o Auto-GPT em uso criativo em todas as áreas. Algumas das aplicações mais comuns do Auto-GPT até agora incluem (mas não estão limitados a):

- Desenvolvimento de sites

- Criação de blogs e artigos com entrada mínima

- Criação de estratégias de marketing eficazes

- Automatizar as interações do usuário, como resenhas de produtos ou livros

- Design gráfico e logotipos comerciais usando geradores de imagem de IA, como DALL-E 2 e Midjourney

- Desenvolvimento de interfaces conversacionais e chatbots

Auto-GPT vs outros agentes de IA

O Auto-GPT não é o único agente de IA autônomo desse tipo. Existem muitos outros, cada um com seu charme e limitações. Aqui estão três das alternativas Auto-GPT mais populares:

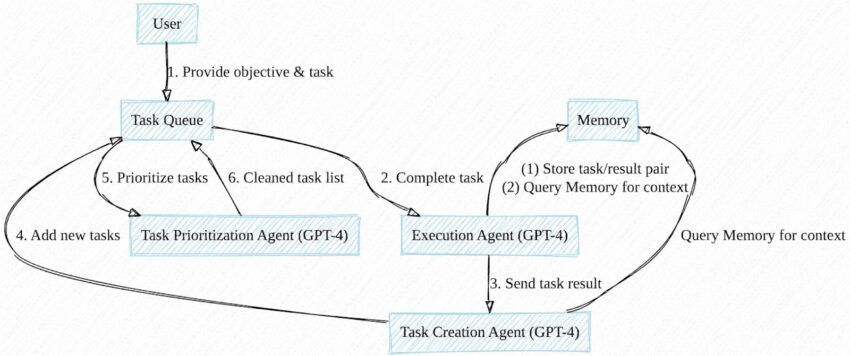

BabyAGI

Assim como o Auto-GPT, o BabyAGI, uma criação de Yohei Nakajima, também está hospedado no GitHub. Ele gera automaticamente, prioriza e executa tarefas alinhadas com um objetivo definido. Você precisa do software Docker e de uma chave de API da OpenAI ou da Pinecone para acessar e usar essa ferramenta.

Em sua essência, BabyAGI é um modelo de linguagem que faz interface com uma lista de tarefas. Ele armazena as tarefas concluídas em um banco de dados, servindo como a “memória” do modelo para contexto ao formular e executar novas tarefas. Embora o script base careça de recursos de pesquisa na Internet ou execução autônoma de código, eles foram introduzidos em versões derivadas.

Microsoft JARVIS

O Microsoft JARVIS, também conhecido como HuggingGPT, é um sistema de modelo multi-IA em que os modelos GPT da OpenAI atuam como o controlador.

O JARVIS incorpora vários modelos de código aberto para processamento de imagens, vídeos, áudio e muito mais. Ele pode se conectar à internet e acessar arquivos. E como BabyAGI & Auto-GPT, avalia as tarefas e escolhe o modelo mais adequado para sua conclusão.

AgentGPT

AgentGPT é uma extensão baseada na web do conceito Auto-GPT/BabyAGI. Você pode iniciar seu agente autônomo por meio de um navegador seguindo as instruções.

Desde a última atualização, o AgentGPT apresenta:

- Memória de longo prazo suportada por banco de dados.

- Navegação na Web e interação com sites e indivíduos

- Salvamento de execuções do agente

Impacto do Auto-GPT no futuro da IA

O Auto-GPT e agentes similares provavelmente representam a próxima fase na evolução da IA. Provavelmente começaremos a testemunhar ferramentas de IA mais inventivas, refinadas, diversas e práticas no devido tempo. Esses avanços têm o potencial de remodelar a forma como trabalhamos, nos dedicamos ao lazer e nos comunicamos. Isoladamente, isso não oferece soluções para os desafios inerentes à IA generativa. Isso varia desde a precisão inconsistente da produção até a possível violação dos direitos de propriedade intelectual e até mesmo o potencial uso indevido da IA para disseminar conteúdo tendencioso ou prejudicial.

Quanto às ameaças de agentes de IA evoluindo ao ponto de superinteligência, o físico e autor de best-sellers Max Tegmark descreveu essa possibilidade de forma bastante sucinta em seu livro de 2017 Life 3.0.

“A verdadeira preocupação não é a malevolência, mas a competência. Uma IA superinteligente é, por definição, muito boa em atingir seus objetivos, sejam eles quais forem, então precisamos garantir que seus objetivos estejam alinhados com os nossos”.